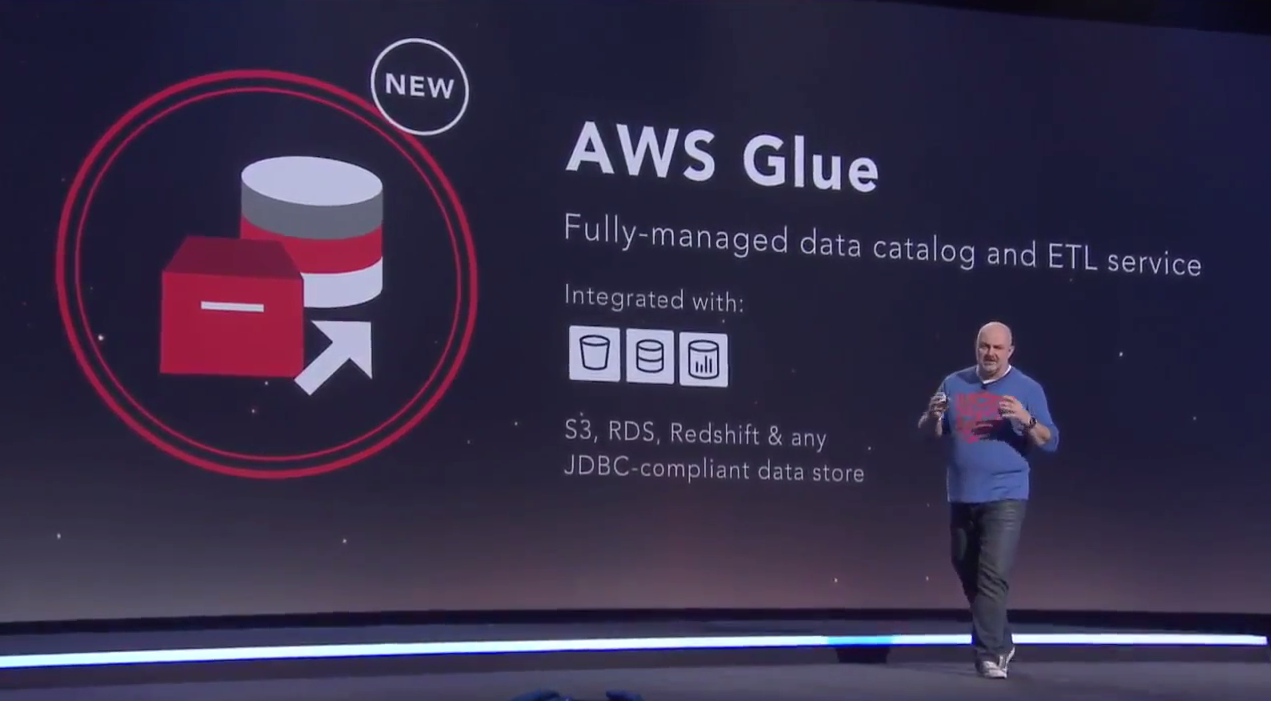

AWS Glue è un servizio ETL completamente gestito che rende facile il trasferimento di dati fra i tuoi datastore. AWS Glue semplifica e automatizza le difficili e lunghe attività di identificazione, conversione, mappatura e pianificazione dei processi dei dati. AWS Glue ti guida attraverso il processo di trasferimento dei tuoi dati con una console di facile uso che ti consente di identificare le origini dei tuoi dati, prepararli per l'analisi e caricarli in modo affidabile dalle origini alle destinazioni.

AWS Glue è integrato con Amazon S3, Amazon RDS e Amazon Redshift, e può essere collegato a qualsiasi datastore compatibile con JDBC. AWS Glue effettua automaticamente ricerche per indicizzazione nelle tue origini dati, ne identifica i formati e suggerisce schemi e trasformazioni, per evitarti di passare tempo a programmare manualmente i flussi di dati. Tutte queste trasformazioni possono essere modificate, se necessario, utilizzando strumenti e tecnologie che già conosci, come Python, Spark, Git e il tuo ambiente di sviluppo integrato preferito (IDE), e condividerli con altri utenti di AWS Glue. AWS Glue pianifica i tuoi processi ETL, effettua il provisioning e ricalibra tutta la tua infrastruttura, in modo che vengano eseguiti in modo rapido ed efficiente su qualsiasi scala. Non hai bisogno di gestire server e paghi solo per le risorse utilizzate dai processi ETL.

Per ricevere informazioni sulla disponibilità del servizio, registrati qui e ti informeremo per e-mail.

Fase 1. Crea il tuo catalogo dati

Prima di tutto, devi utilizzare la Console di gestione AWS per registrare le tue origini dati con AWS Glue. AWS Glue effettua ricerche per indicizzazione nelle tue origini dati e crea un catalogo dati utilizzando classificatori predefiniti per molti formati di origine comuni, fra cui JSON, CSV, Parquet e altri. Puoi anche aggiungere i tuoi classificatori o selezionarli dalla community AWS Glue per aggiungerli alle tue ricerche.

Fase 2. Genera e modifica le trasformazioni

Poi seleziona un'origine dati e una destinazione e AWS Glue genererà un codice Python per estrarre i dati dall'origine, trasformarli in modo che corrispondano allo schema della destinazione e caricarli nella destinazione. Il codice generato automaticamente gestisce gli errori comuni, come i dati non validi o gli errori hardware. Puoi modificare questo codice utilizzando il tuo IDE preferito ed eseguire test con i tuoi dati di esempio. Puoi anche esplorare il codice condiviso da altri utenti di AWS Glue e inserirlo nei tuoi processi.

Fase 3. Pianifica ed esegui i processi

Infine, puoi usare la flessibile utilità di pianificazione di AWS Glue per eseguire i flussi su basi ricorrenti, in risposta ai trigger, o anche in risposta agli eventi di AWS Lambda. AWS Glue distribuisce automaticamente i processi ETL su nodi di Apache Spark, in modo che il tempo di esecuzione di ETL rimanga costante con la crescita del volume di dati. AWS Glue coordina l'esecuzione dei processi nella sequenza giusta e riprova automaticamente in caso di errore. AWS Glue ricalibra in modo elastico l'infrastruttura necessaria per completare i processi nei tempi e ridurre al minimo i costi.

Fatto.

È tutto! Quando i processi ETL sono in produzione, AWS Glue ti consente di tenere traccia delle modifiche ai metadata quali le definizioni di schemi e i formati dei dati, per permetterti di tenere aggiornati i processi ETL.

AWS re:Invent è la più grande conferenza dedicata alla community globale di AWS. Questa conferenza permette di approfondire i servizi AWS e apprendere best practice. Il servizio AWS Glue è stato annunciato al re:Invent 2016. Guarda la sessione di seguito per ulteriori informazioni su AWS Glue e altre analisi correlate, oppure riproduci la playlist con tutte le sessioni sui Big Data.

Registrati per accedere al programma di anteprima di AWS Glue in questa pagina. Una volta approvata la richiesta, potrai provare gratuitamente il servizio.